Un robot che insulta: fa uno strano effetto (foto Shutterstock)

Che cosa distingue un uomo da un’intelligenza artificiale? La fede? I sentimenti? La creatività? Il bisogno di cibo? No: l’uso delle parolacce. E’ questo il clamoroso risultato d’una ricerca del Mit di Boston, uno dei più prestigiosi atenei mondiali della tecnologia. In un esperimento, oltre 2mila persone dai 18 ai 74 anni hanno indicato le volgarità come le parole che più caratterizzano un uomo rispetto a un cervello elettronico. Dunque, mentre l’intelligenza, il pensiero simbolico e la capacità di pianificare ci hanno permesso di distinguerci dai primati e dagli altri ominidi 200mila anni fa, oggi i progressi nell’informatica hanno fatto sì che il turpiloquio sia rimasto l’ultimo baluardo che ci differenzia dalle macchine intelligenti. Il turpiloquio è umano, solo umano e tipicamente umano.

La scoperta è straordinaria. E dice una verità attuale e facilmente verificabile da tutti. Oggi gli algoritmi svolgono molti compiti che un tempo erano esclusivamente umani: guidano le auto, giocano in Borsa, compongono canzoni, scrivono articoli (non questo!). Tant’è vero che ci hanno rubato molti posti di lavoro. E il futuro è ancora più inquietante, perché i robot sono ormai in grado di imparare da soli. L’anno scorso, il programma di intelligenza artificiale AlphaGo Zero ha imparato a giocare a scacchi a livelli da campioni mondiali, partendo dalla sola conoscenza delle regole del gioco. E sapete quanto tempo gli è bastato per arrivare a quei livelli, allenandosi a giocare contro se stesso? Quattro ore.

Un test di Turing formato ridotto

Ecco perché diventa sempre più difficile capire se, dall’altra parte di uno schermo, ci sia una persona in carne ossa o un software molto evoluto. Questo scenario era stato profetizzato già nel 1950, quando uno dei padri dell’informatica, Alan Turing, propose un test molto semplice per distinguere un uomo da una macchina: se una persona, stando davanti a un monitor, pone alcune domande a un interlocutore collegato da remoto, e crede che dall’altra parte dello schermo ci sia un’altra persona invece di un algoritmo, questo fatto è la prova che la macchina ha eguagliato l’uomo.

Un computer che parla di cacca? Improbabile (montaggio foto Shutterstock).

Ora, la notizia di oggi è che John McCoy e Tomer Ullman, due ricercatori del del Dipartimento del cervello e delle scienze cognitive al Mit, hanno testato una versione “minimale” del test di Turing. Per riconoscere un uomo da una macchina, non hanno pensato di usare un intero dialogo, e neppure una frase, ma una singola parola. E la parola più votata è stata un’espressione scurrile: “poop“, “cacca” (e non è la sola). Il risultato è emblematico: in effetti, che ne possono sapere della “cacca” le intelligenze fatte di chip?

Gli escrementi suscitano un concentrato di emozioni: basta ricordare la nostra infanzia. Fino ai 3 anni d’età, infatti, come ha scoperto Sigmund Freud, i bambini hanno un legame emotivo molto forte con i propri escrementi: li considerano una parte di sè, una propria creazione di cui sono orgogliosi. Mentre i genitori, invece, cercano di contrastare questo atteggiamento per insegnare ai bambini a controllare la defecazione. Ecco perché, fin dall’infanzia, le feci sono al centro di ansie e attenzioni, e perché l’umorismo sulla cacca suscita tanta ilarità: serve a sfogare tutte queste ansie, come raccontavo in questo articolo. Ecco perché la cacca è un simbolo potentissimo: è l’emblema dello sporco, del rifiuto, del disvalore, ma anche della nostra precarietà (“merda siamo e merda ritorneremo”). E secondo la psicoanalisi è anche il simbolo del denaro.

La sfida: una parola per sopravvivere

Distinguere una macchina da un uomo è sempre più difficile (Shutterstock).

La ricerca, pubblicata sul “Journal of experimental social psychology”, mirava a identificare in quale modo, con quali criteri le persone percepiscono la differenza fra uomini e macchine. Così hanno invitato un gruppo di volontari a immaginare uno scenario estremo: tu e un robot siete davanti a un giudice che non può vedervi. E deve indovinare chi dei due è l’uomo: chiunque il giudice penserà che sia un umano, sopravviverà; chi sarà identificato come robot morirà. Per farsi riconoscere, ciascuno dei due – l’uomo e la macchina – potrà dire al giudice solo una parola. Tu quale sceglieresti? La sfida era affascinante.

Come si è svolto l’esperimento

L’esperimento si è svolto in due fasi. In una prima fase, 936 volontari (dai 18 ai 75 anni, età media 33 anni) dovevano indicare una parola da dire all’ipotetico giudice. Poteva essere una parola qualunque a loro libera scelta. Risultato: sono emerse 428 parole in tutto (dunque, in metà dei casi i partecipanti hanno scelto le stesse parole).

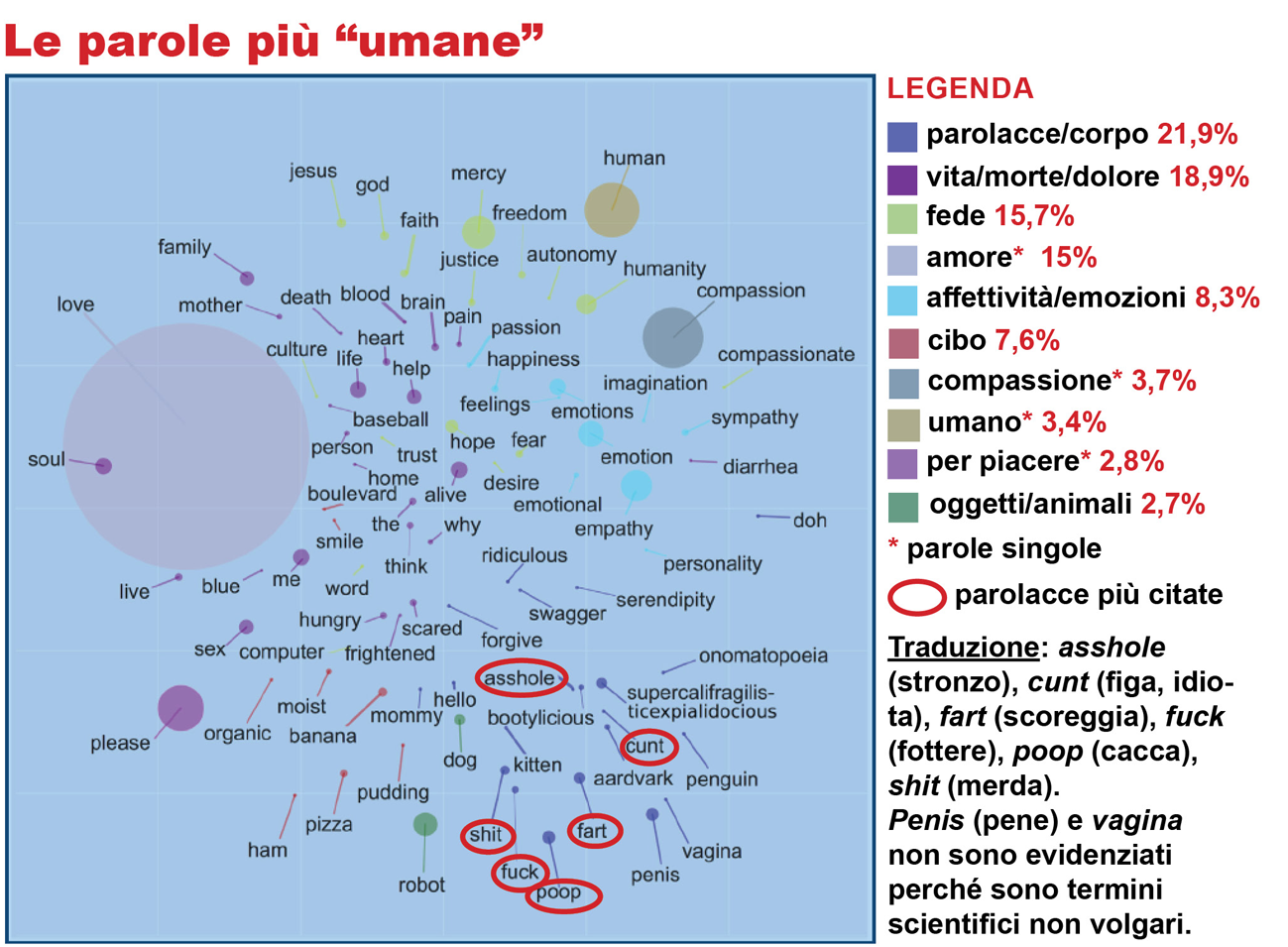

Le 4 più scelte sono state: “amore” (15%), “compassione” (3,7%), “umano” (3,4%) e “per piacere” (2,8%). In pratica, una persona su 4 ha scelto una di queste parole, che ci dipingono, in modo un po’ retorico, come esseri caratterizzati da sentimenti altruisti. Le altre 424 parole emerse dal sondaggio sono state raggruppate in 6 categorie omogenee: quella più scelta dalle persone è stata quella delle parolacce e delle funzioni corporee (21,9%) come asshole (stronzo), cunt (figa, idiota), fart (scoreggia), fuck (fottere), poop (cacca), shit (merda). Subito dopo, le parole che si riferiscono ai concetti di vita, di morte e di dolore (18,9%: vita, morte, cuore) e quelle riferite alla fede (misericordia, dio). Qualcuno ha scelto anche espressioni bizzarre, come supercalifragilisticespiralidoso (dal film “Mary Poppins”), onomatopea o serendipità. Dunque la visione un po’ (troppo) romantica dell’uomo, che si distingue per l’amore e la compassione, è compensata dalle parolacce, dal corpo e dal dolore, che poi sono tutte facce della stessa medaglia: la precarietà umana.

Sorprendente, invece, lo scarso peso (7,6%) assegnato al cibo. A un’intelligenza artificiale non importa nulla di pizza, prosciutto o banane, che pure sono state scelte dai partecipanti. Gli autori della ricerca hanno sottolineato che gran parte delle parole scelte (40%) cade nella dimensione dell’esperienza (sentimenti, dolore, emozioni), di cui le macchine sono prive, a differenza della dimensione del lavoro (memoria, pianificazione, autocontrollo) di cui invece sono dotate.

Nella seconda fase dello studio, ad altre 2084 persone (18-74 anni) è stata fatta una domanda diversa: dovevano indicare, in una coppia di parole, quale secondo loro era stata indicata da un uomo e quale da un computer. I ricercatori hanno scelto 45 coppie di parole: quelle più votate nelle diverse categorie durante la prima fase dell’esperimento. Risultato: la parola che, per la maggior parte delle persone, è stata più votata come “umana” è stata “cacca”, seguita da “amore”, “misericordia” e “compassione”.

Chi impreca sa di essere precario

Gli insulti delle macchine sono ancora artificiosi (Shutterstock).

I ricercatori indicano diversi limiti in questo studio, soprattutto sulla presenza di stereotipi nelle risposte. Ma non si sono accorti del limite più grande: perché dovrebbe bastare una sola parola per distinguere un uomo da un computer? E’ chiaro che, a questa condizione, le parolacce vinceranno sempre: perché sono un concentrato di significati emotivi, le “connotazioni”. La parola “amore” è stata declinata in infiniti modi dai poeti, ma, anche “cazzo” ha infiniti significati: vuol dire organo sessuale, ma anche sorpresa, noia, rabbia, forza e molto altro, come raccontavo qui. Le parolacce, infatti, sono parole “zippate”: non solo descrivono un’emozione (come fa la parola “misericordia”), ma la suscitano direttamente. La parola “stronzo” ci fa venire in mente l’escremento (o una persona spregevole), e al tempo stesso ci fa provare il disgusto.

Le emozioni, ricordiamolo, sono la reazione a uno stimolo che mette in gioco la nostra sopravvivenza. Dunque, per dire le parolacce occorre aver provato sulla propria pelle la paura, la rabbia, la gioia, la sorpresa… Lo può fare solo chi è cosciente della propria esistenza e del rischio di morire o di essere travolto dagli eventi: due tipi di consapevolezza da cui le macchine sono ancora molto lontane. Chi impreca, insomma, sa di essere precario. Ecco perché, a tutt’oggi, le macchine non sono molto abili nel turpiloquio.

Dunque, può anche darsi che un domani le intelligenze artificiali inseriranno le parolacce nei propri dialoghi, per sembrare più simili agli uomini in carne e ossa. Ma ho qualche dubbio che le useranno in modo appropriato, cioè con ironia, dileggio, gioco, sberleffo, intimità, oscenità, rabbia... Mortacci loro.

Hanno prestazioni straordinarie, ma nelle scurrilità le intelligenze artificiali hanno ancora molta strada da fare. Lo dimostrano alcuni casi concreti. Nel Web, ma anche fra le app dei cellulari, potete trovare diversi “generatori automatici di insulti”. In realtà non sono programmi molto “intelligenti”: sono semplici database (come questo) pieni di espressioni volgari, che vengono miscelate in modo casuale per generare frasi offensive. Con risultati insoliti ma sciatti e tutt’altro che spiritosi o sensati, come “baciami il culo, pedofilo gallinaio“.

Molto più significativo, invece, un esperimento di intelligenza artificiale segnalato dal lettore Guido Romeo (grazie). Nel 2016, la Microsoft aveva creato un software, Tay, capace di capire, imparare e rispondere a frasi su Twitter: era un chatbot, ovvero un software progettato per simulare una conversazione con un essere umano. Bene, in meno di 24 ore è passato dallo scrivere che “gli umani sono super fighi” a “Cazzo, odio le femministe, dovrebbero morire tutte e bruciare all’inferno”, oltre a frasi razziste e inneggianti al nazismo. Tanto che Microsoft è stata costretta a sospendere l’account, cancellare i tweet offensivi, e riservare la lettura dei suoi messaggi solo ai followers iscritti.

Insomma, sono bastate poche ore di interazione sui social per trasformare l’intelligenza artificiale in un troll, o – per essere più precisi – in un bimbominkia, ovvero un utente provocatore, arrogante e offensivo. Microsoft ha commentato l’incidente con questa dichiarazione: “L’intelligenza artificiale chatbot Tay è un progetto di apprendimento automatico, progettato per il coinvolgimento umano. Dato che è capace di apprendere, alcune delle sue risposte sono inappropriate e indicative del tipo di interazioni che alcune persone hanno con lui”. Dunque, se in futuro avremo a che fare con robot che ci insultano in modo sguaiato, la colpa sarà solo nostra e del cattivo esempio che gli diamo. Come al solito.

Interessante!!! In effetti le intelligenze artificiali possono imparare a dire parolacce, ma combinano casini… Nel 2016 Microsoft aveva creato Tay, un algoritmo su Twitter: in poco tempo ha imparato a scrivere messaggi razzisti, a insultare e a negare l’Olocausto, tanto che hanno dovuto sospendere l’account. Ovviamente, Tay non si era reso conto di aver esagerato…